无需训练,即插即用,2倍GPU端到端推理加速——视频扩散模型加速方法DraftAttention

本文第一作者为美国东北大学博士生沈轩,研究方向为高效人工智能,专注于在 gpu、移动端、fpga 与 asic 等多种硬件平台上实现大模型的高效部署与加速。第二作者为香港中文大学的韩晨夏,其研究聚焦于计算机体系结构与 ai 系统的高效化设计。

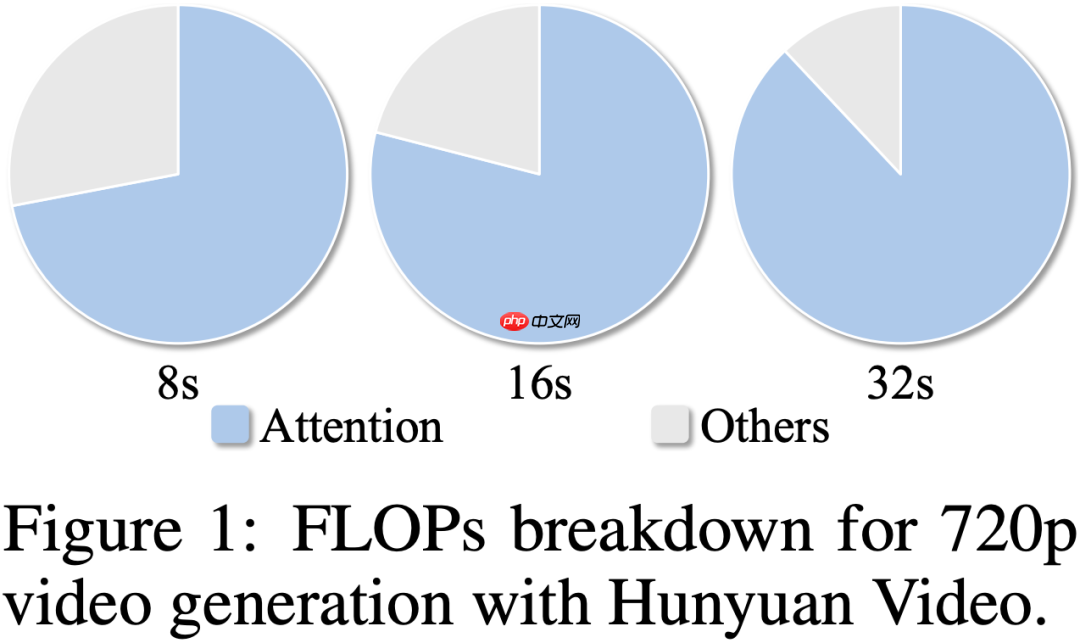

在高质量视频生成任务中,扩散模型已成为主流技术。然而,随着视频时长和分辨率的提升,Diffusion Transformer(DiT)中的注意力机制计算量急剧上升,成为推理效率的核心瓶颈。这是因为 DiT 通常采用 3D 全局注意力来建模时空一致性,虽然效果显著,但其计算复杂度随 token 数量呈平方增长,带来巨大开销。以 HunyuanVideo 为例,注意力模块耗时占比超过 80%,仅生成 8 秒 720p 视频就需近一小时。因此,提升视频生成模型的速度迫在眉睫。

当前主流加速方法如 Sparse VideoGen(https://www.php.cn/link/982e5bfb1002e50e4c0cb2d3d144b55a AdaSpa(https://www.php.cn/link/60f24162e3a72b51963ce5956bda2ab4 GPU 上取得一定端到端加速效果。但受限于稀疏度不足及固定稀疏模式,这些方法难以实现内容感知的细粒度调控,缺乏对输入动态变化的适应能力。因此,亟需一种无需训练、硬件友好且具备动态调节能力的稀疏注意力机制,以推动视频扩散模型的实际应用。

近期,来自美国东北大学、香港中文大学及 Adobe Research 的联合团队提出了一种即插即用、无需训练的动态稀疏注意力加速方案——DraftAttention。该方法大幅降低注意力计算负担,在几乎不牺牲生成质量的前提下,实现高达 2 倍的 GPU 端到端推理加速。

论文标题:DraftAttention: Fast Video Diffusion via Low-Resolution Attention Guidance

arXiv 地址:https://www.php.cn/link/bb9cad607e756782441e479ff3d13c8a

GitHub 主页:https://www.php.cn/link/2f1f0bdbb82e8f2a7ab031d8f2a13ee1

背景挑战

视频生成中,注意力模块是推理效率的主要瓶颈。如图所示(Figure 1),在 HunyuanVideo 中,当视频时长从 8 秒增至 32 秒,注意力计算量(FLOPs)占比迅速攀升至 90%以上,尤其在高分辨率下更为突出。根本原因在于:视频模型普遍使用时空全局注意力,其复杂度随 token 数量平方增长,而 token 数量又正比于帧数与空间分辨率——一旦提升清晰度或长度,计算量呈指数级上升,严重拖慢推理速度,难以满足部署需求。

因此,引入稀疏注意力是有效路径。但现有方法多采用固定稀疏模式,无法根据文本提示、视频语义或扩散过程中的中间状态灵活调整,导致高稀疏率下质量明显下降。为此,设计一种能自适应输入语义与扩散步长的“动态稀疏”机制,成为维持生成质量的关键。

问题建模

视频生成常借助 3D VAE(变分自编码器)将原始视频压缩至隐藏空间(latent space),大幅减少 token 数量,同时保留核心结构信息。该空间具有三维形态(T×H×W),其中 T 表示压缩后帧数,H 和 W 对应空间维度。我们进一步观察到隐藏空间存在显著时空冗余:并非所有 latent token 都同等重要。基于此,本文提出关键思路——跳过低重要性 token 的注意力计算,在减少冗余的同时保留关键特征,从而实现高效加速且不损质量。

方法概览

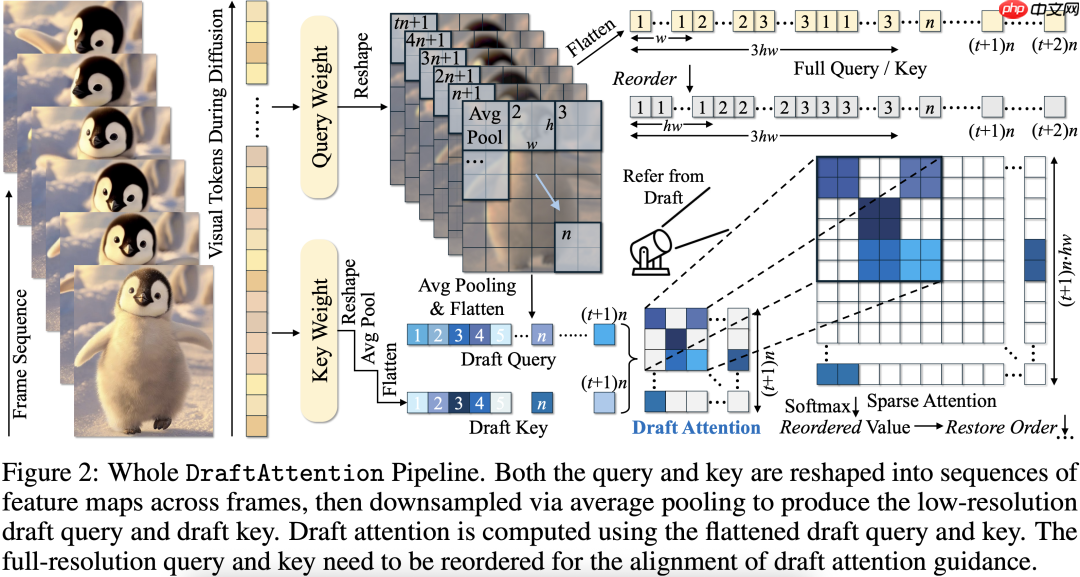

为此,研究团队提出 DraftAttention:一种无需训练、动态可调、硬件友好的稀疏注意力机制。其核心思想为:

利用低分辨率“草图注意力图”快速估计 token 重要性,并据此指导高分辨率注意力的稀疏模式选择。

具体流程如下:

- 草图构建:对隐藏特征图进行空间下采样(如 8×8 平均池化),生成低分辨率 Query 与 Key;

- 草图注意力计算:基于下采样后的 Q/K 计算 Draft Attention Map,识别最具信息量区域;

- 稀疏模式引导:从草图中选取得分最高区域,生成结构化稀疏 Mask,用于指导高分辨率注意力;

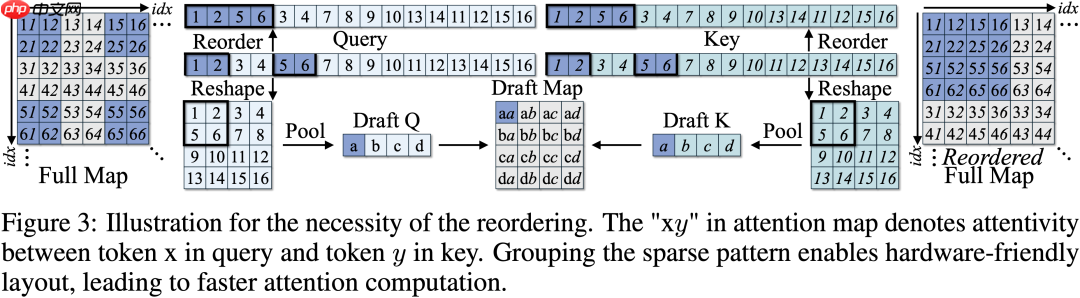

- Token 重排优化硬件执行:为使稀疏区域连续分布、契合 GPU memory layout,提出 token 重排策略,显著提升稀疏计算效率;

- 即插即用、无需训练:该机制可无缝集成至现有视频扩散模型(如 HunyuanVideo、Wan2.1),无需额外训练或微调。

这一设计既从计算图层面削减冗余,也从系统执行角度增强稀疏算子的硬件亲和力,实现速度与质量双赢。

值得一提的是,DraftAttention 并非经验启发式方法,而是建立在坚实的理论基础之上。我们从两个维度证明其有效性:

- 近似误差可控:平均池化构建的 Draft Attention Map 与原图之间的 Frobenius 范数差异有界,且随 token 空间连续性增强而减小;

- 稀疏掩码误差有界:由草图提取的稀疏注意力模式引入的计算偏差同样可被严格限定在可控范围内。

两项理论结果共同表明:草图注意力在提供高质量稀疏引导的同时,不会破坏原始注意力机制的表达能力,为 DraftAttention 的实际表现提供有力支撑。

实验结果

我们在 HunyuanVideo 与 Wan2.1 等主流视频生成模型上全面评估 DraftAttention,重点关注生成质量与推理加速两方面。

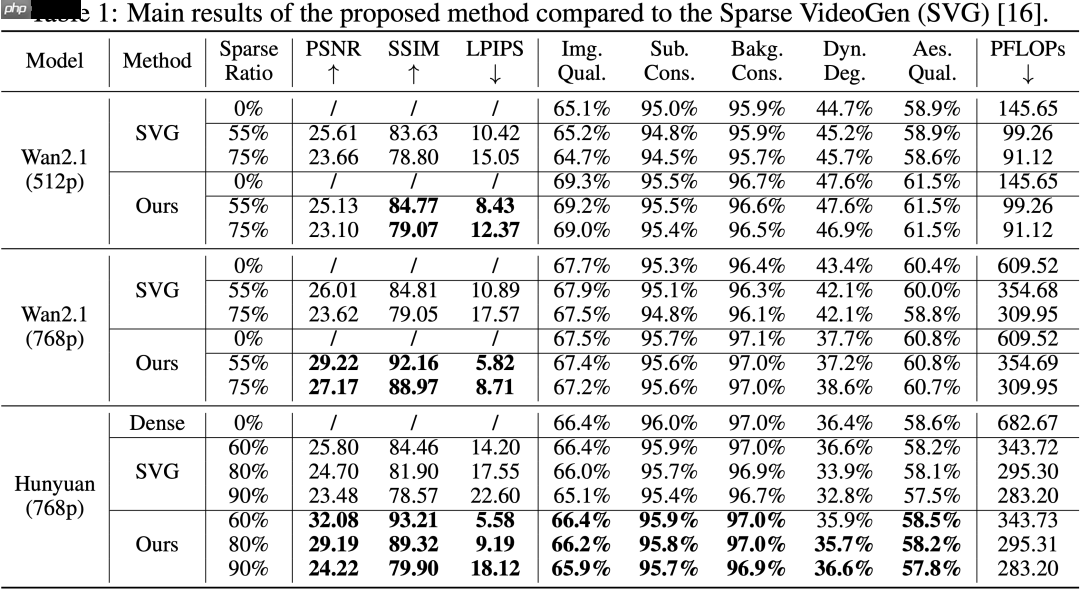

对比代表性稀疏方法 Sparse VideoGen (SVG),在相同计算量下 DraftAttention 显著更优:

- PSNR ↑:高分辨率下提升约 +2~+3 分;

- SSIM ↑:结构一致性更强,视频更稳定;

- LPIPS ↓:感知相似度更高,视觉更贴近真实;

- VBench 多项指标(图像质量、主体一致性、背景连续性等)全面优于 SVG。

尤其在高稀疏率(75%~90%)下,DraftAttention 能更好保持时空一致性与关键结构,而 SVG 等静态方法常出现模糊、断帧等问题。

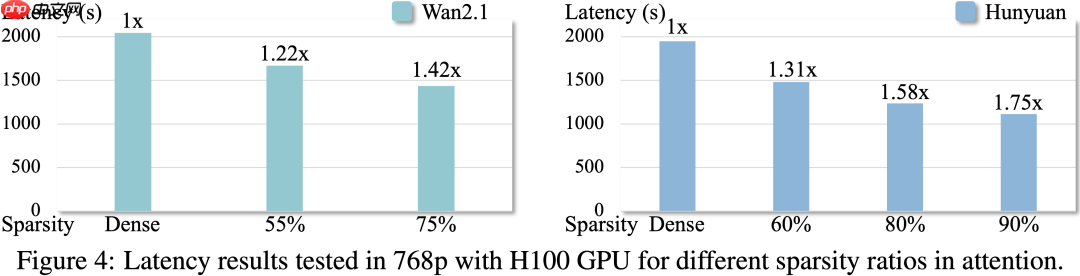

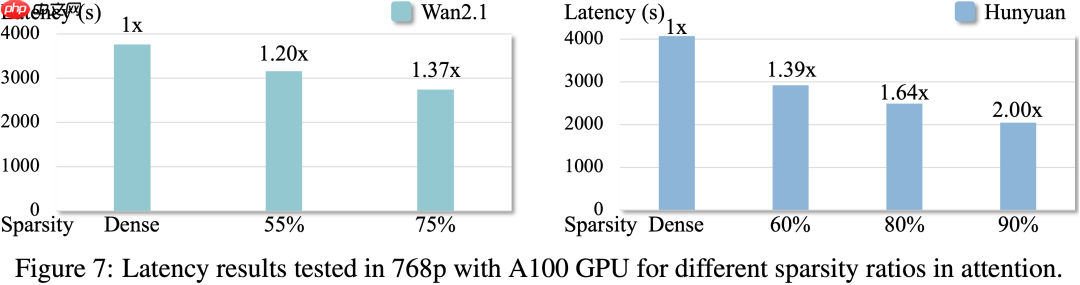

在 NVIDIA H100 与 A100 GPU 上测试端到端加速效果:

- 最高实现 1.75× 推理加速;

- 加速比随视频长度、分辨率与稀疏率同步提升,扩展性强;

- 得益于 token 重排策略,稀疏注意力更具硬件友好性,执行效率显著提高。

此外,我们提供多个 prompt 下的生成结果对比:

Prompt: "The banks of the Thames, as the camera moves vertically from low to high."