蚂蚁百灵大模型团队发布 Ling-1T:万亿参数“非思考”模型、基于 MoE 架构

蚂蚁百灵大模型团队今日正式推出ling 2.0系列首款旗舰级非思考型模型——ling-1t,该模型具备高达万亿参数的规模。

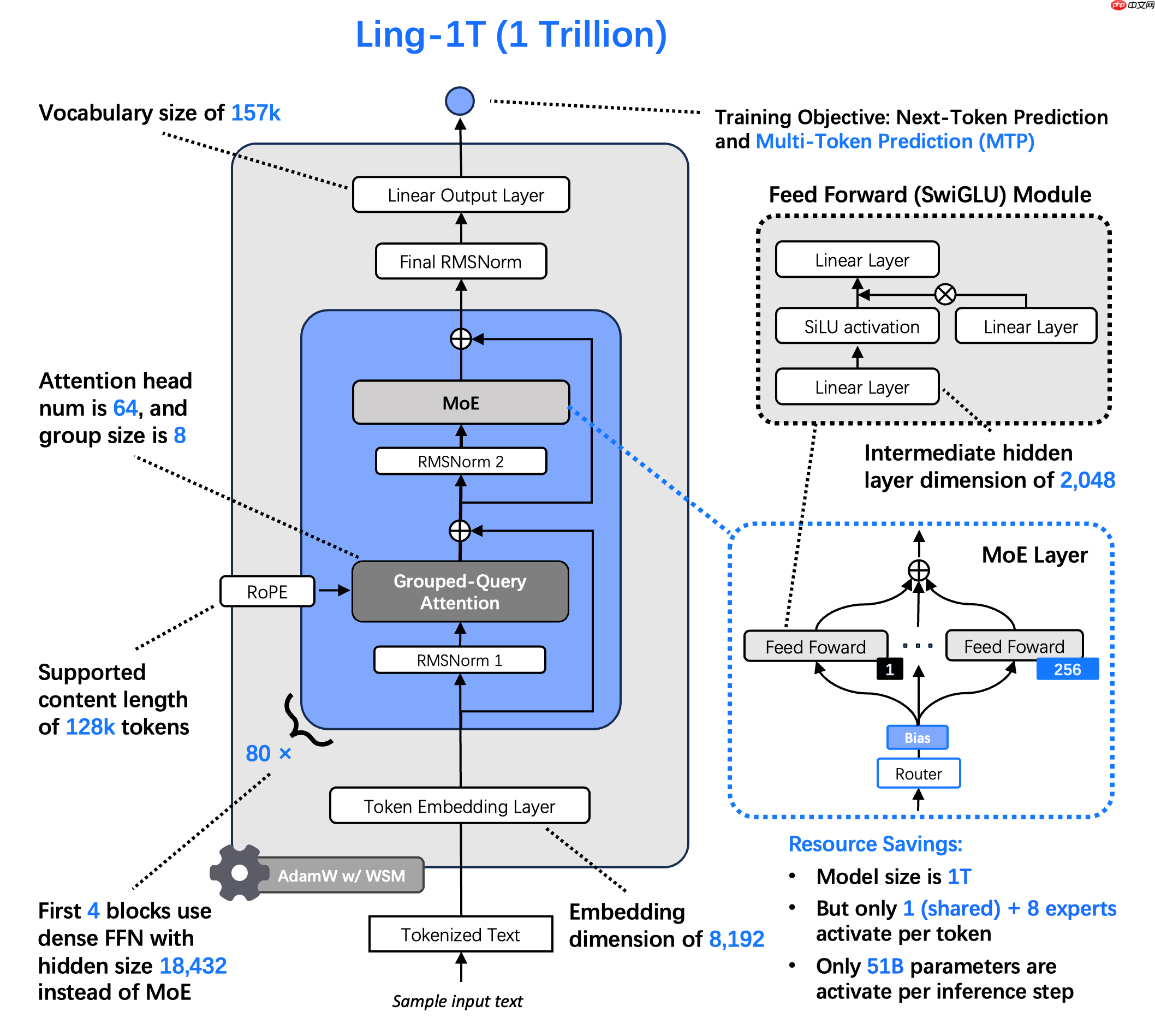

Ling-1T延续了Ling 2.0的整体架构设计,如其命名所示,总参数量已达1T(Trillion,即万亿),在每token生成过程中激活约50B参数。

该模型的基础版本Ling-1T-base在超过20T token的高质量、高推理密度语料上完成了预训练,支持最长128K的上下文窗口,并通过“中训练+后训练”阶段构建的演进式思维链(Evo-CoT)显著增强了高效推理能力。

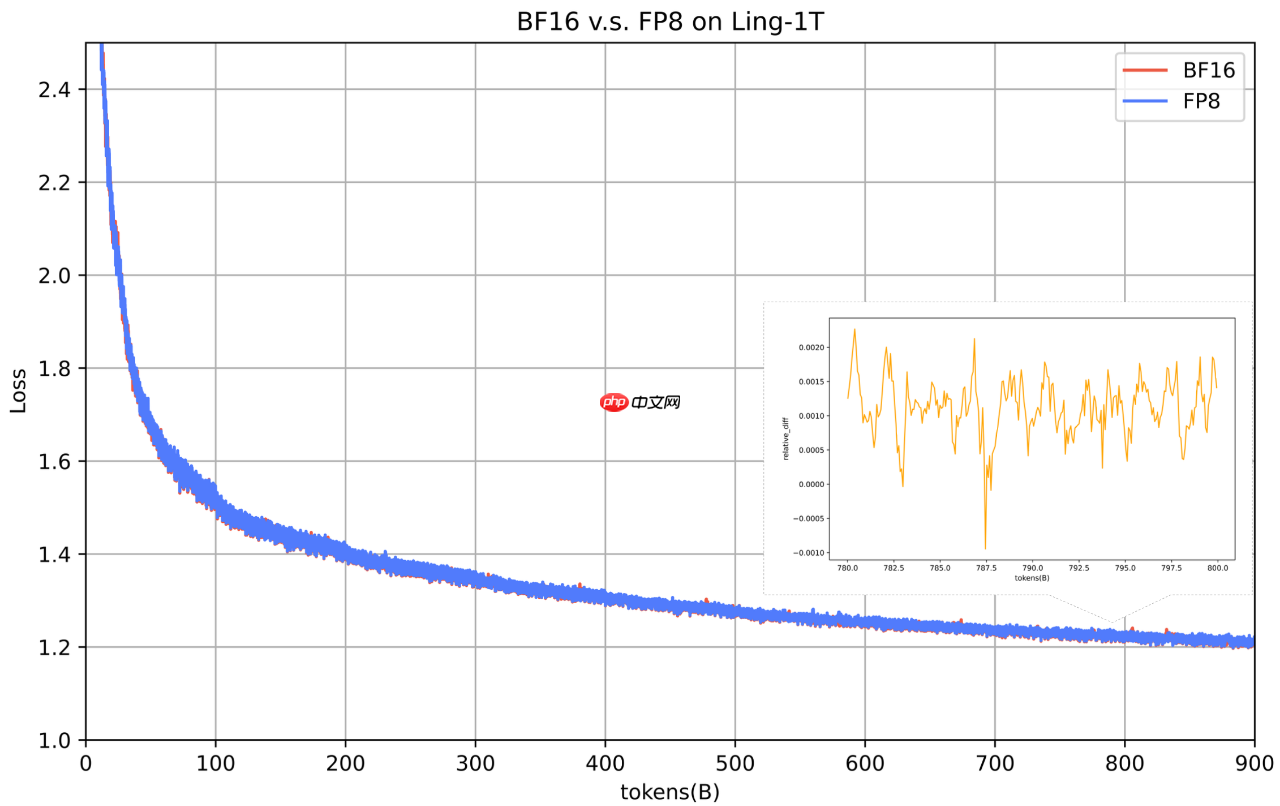

Ling-1T全程采用FP8混合精度训练技术(部分相关方法已对外开源),是目前公开的最大规模使用FP8进行训练的基座模型。这一技术路线带来了显著的显存优化、更灵活的模型并行切分策略,并实现了端到端训练速度提升超过15%。

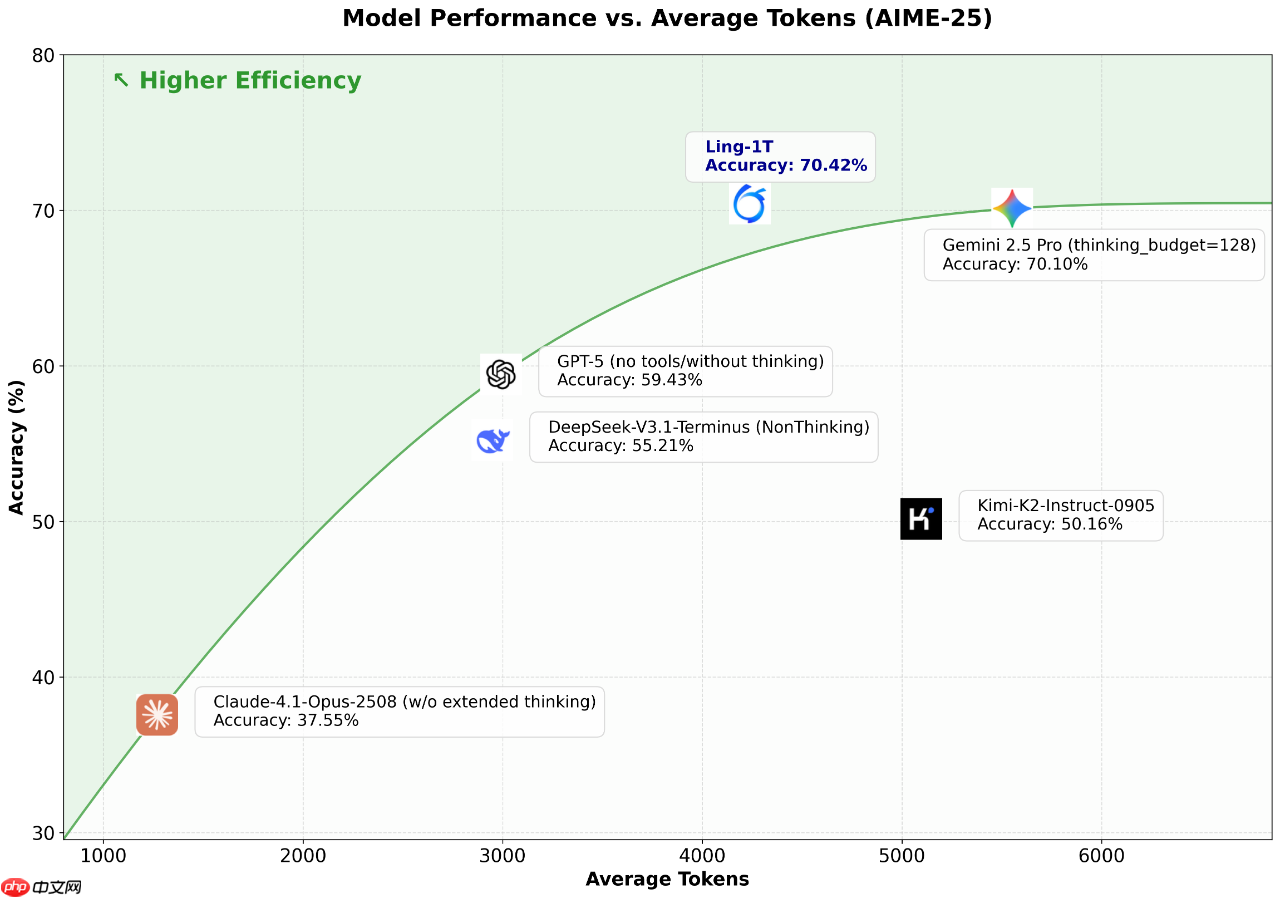

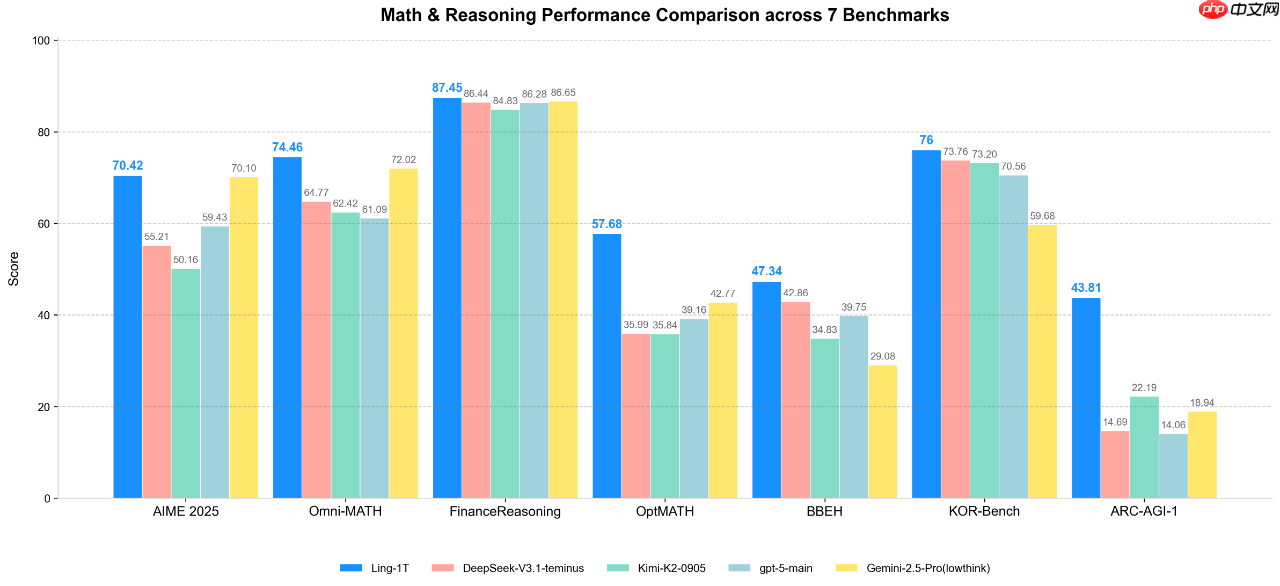

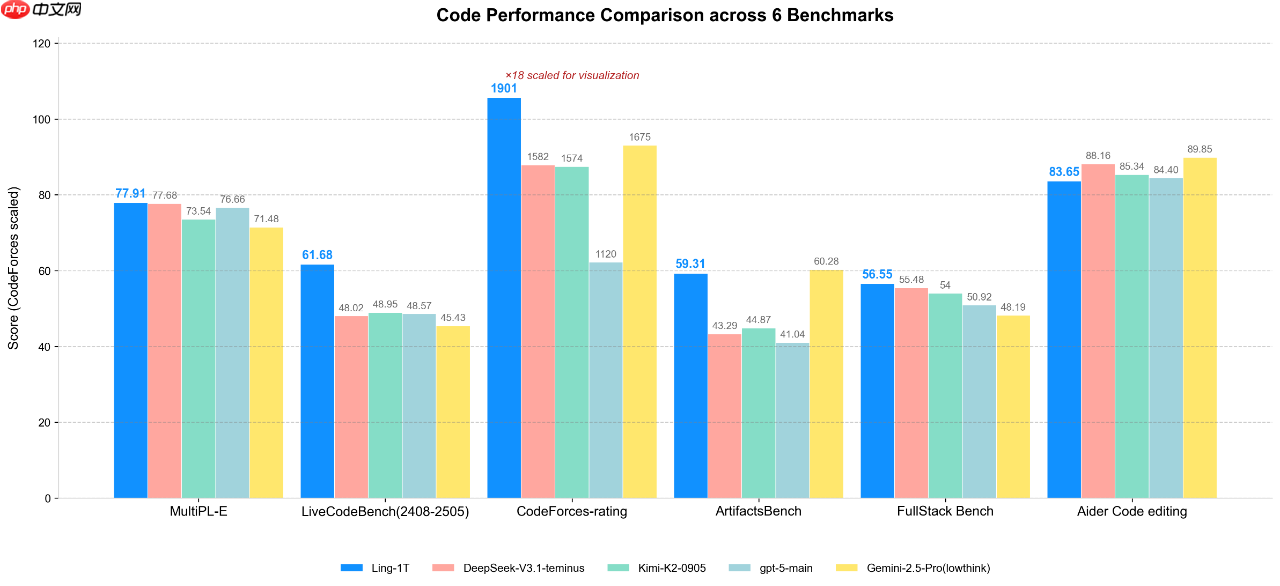

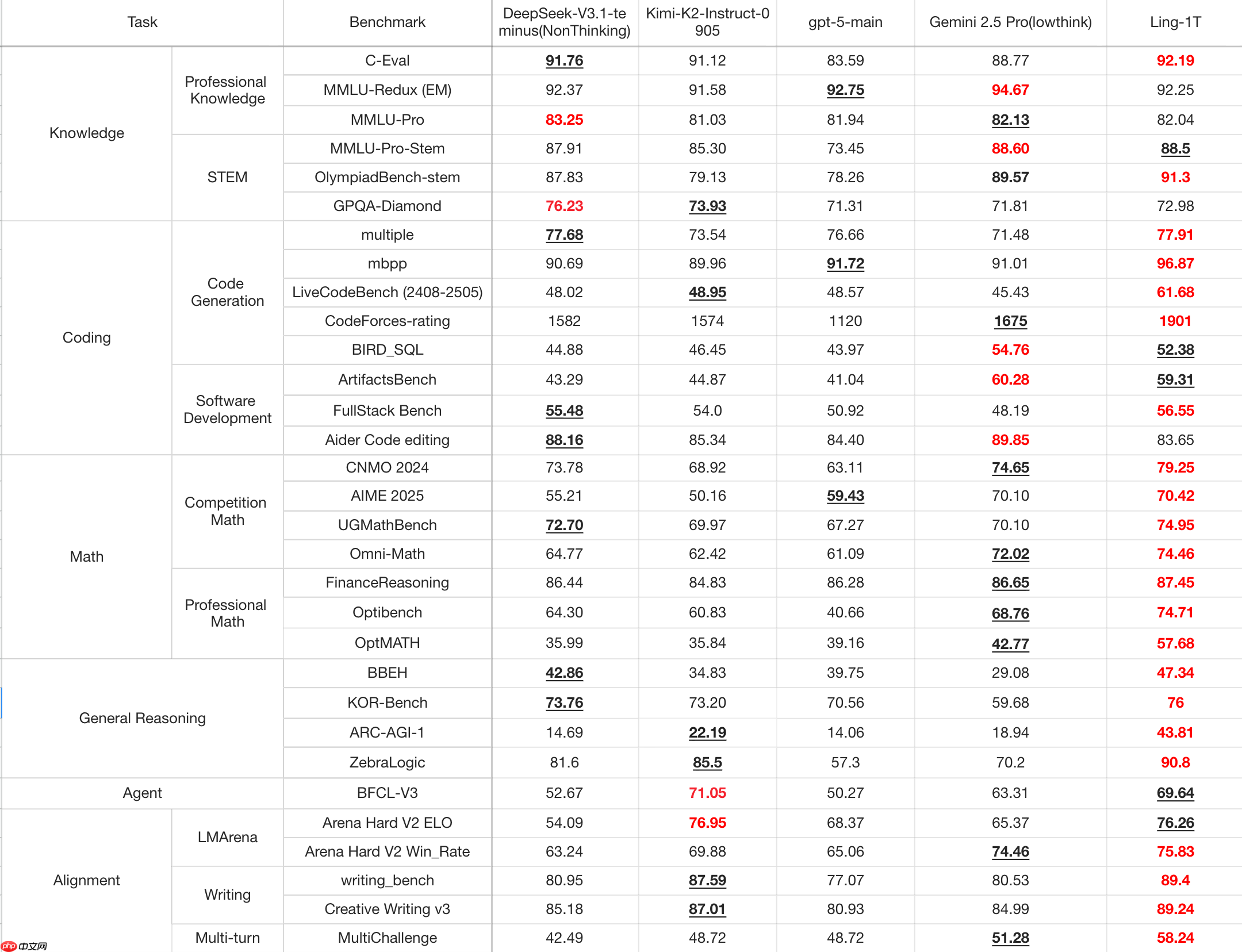

据官方介绍,在输出token受限的场景下,Ling-1T于多个复杂推理基准测试中达到SOTA水平,展现出在高效响应与精准推理之间出色的平衡能力。

开源仓库及体验入口:HuggingFace:https://www.php.cn/link/f5cfb8cbfcd2fdd60665099993430d6b ModelScope:https://www.php.cn/link/41d877641441a7e1b49002de4cbf7ad3 GitHub:https://www.php.cn/link/857cd81e6a7d216eeaf1946a803a7d5e Ling chat(国内用户访问):https://www.php.cn/link/c96742836bff214c3bb498c11c10ea4d ZenMux(面向海外开发者,提供Chat体验与API服务):https://www.php.cn/link/038e12b8ef41273a9ed83a46a130c0a3

下一篇 >>

网友留言(0 条)