DeepMind 推出 “帧链” 概念:视频模型或将实现全面视觉理解

DeepMind 最新研究提出了一项突破性理念——“帧链”(Chain-of-Frames, CoF),这一概念可视为视觉领域的“思维链”(CoT)。正如链式思维让大语言模型具备符号推理能力,帧链则赋予视频生成模型在时空维度上进行连贯推理的能力,仿佛为其注入了自主的视觉思维。

该团队在论文中抛出了一个极具挑战性的问题:视频模型是否也能像大型语言模型(LLM)那样,无需针对特定任务专门训练,就能完成多样化的视觉理解任务?当前的计算机视觉系统仍处于碎片化阶段,每项任务如目标检测、语义分割等都需要独立设计与训练模型,缺乏统一的通用性。

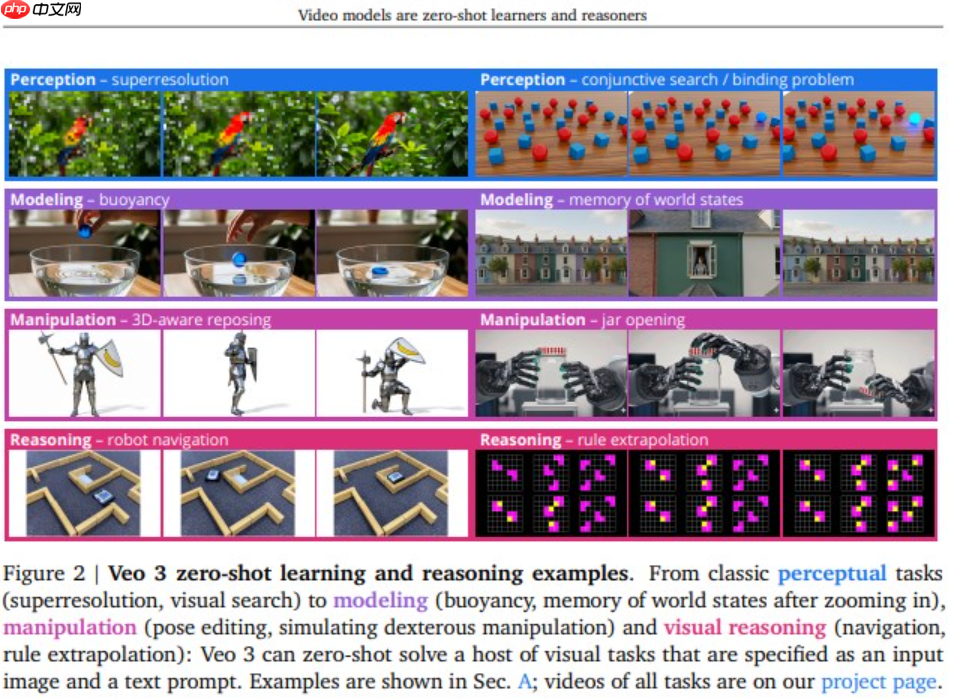

为验证这一设想,研究人员采用极简方式测试:仅输入一张初始图像和一段文字指令,要求模型自动生成一段分辨率为720p、时长8秒的视频。这种提示驱动的方式模仿了大模型的零样本推理机制,旨在挖掘视频模型内在的泛化潜力。

实验结果令人震惊:Veo3 模型在多项标准视觉任务中展现出卓越表现,不仅具备基础的感知与建模能力,还能对复杂场景进行动态操控。尤其在涉及跨时间与空间的视觉推理任务中,它能自主规划合理的动作路径,成功应对多步骤视觉难题。

研究最终归纳出三大关键发现:

- 广泛的任务适应性:Veo3 能够处理大量未曾专门训练过的视觉任务,显示出接近通用视觉系统的潜力。

- 初步视觉推理能力:通过生成的视频序列分析,模型展现出类似“帧链”的推理过程,逐步构建对环境的理解。

- 快速进化趋势:尽管专用模型目前仍具优势,但 Veo3 的进步速度惊人,预示着通用视觉模型的时代可能即将到来。

DeepMind 预测,未来的通用视频模型或将逐步取代传统专用模型,正如 GPT-3 奠定了大语言模型的基础地位一样,新一代视觉模型有望成为多任务视觉智能的核心平台。

下一篇 >>

网友留言(0 条)